Cet été, les grands noms de l’IA ont redoublé d’annonces. Depuis juin, Gemini 2.5 Pro s’est invité dans la recherche Google ; Meta recrute massivement pour bâtir sa super-intelligence ; Anthropic a dévoilé début août Claude Opus 4.1, dopant ses capacités de codage ; et OpenAI a multiplié les nouveautés : mode agent, mode étude (study mode), un modèle open source gpt-oss… avant de sortir, en fanfare la semaine dernière, son très attendu GPT-5.

Un feu d’artifice technologique qui, à écouter les discours officiels, nous rapprocherait de l’AGI, cette intelligence artificielle générale censée tout faire pour nous. Mais derrière ce ton triomphal, la révolution annoncée semble encore tenir de l’horizon lointain plutôt que du présent tangible.

Le mode agent : l’IA qui passe à l’action

Parmi ces nouveautés, le mode agent de ChatGPT intrigue. Finie l’IA cantonnée au rôle d’assistant docile : elle peut désormais chercher, analyser, décider… et surtout agir sans nous solliciter à chaque étape.

Bienvenue dans l’ère de l’IA agentique, ces systèmes quasi autonomes capables de mener des tâches complexes de bout en bout. Du moins, en théorie.

Car derrière l’effet d’annonce, le mode agent illustre surtout un point clé : l’écart qui persiste entre ce que l’IA promet et ce qu’elle délivre réellement aujourd’hui.

Un agent plus spectaculaire qu’efficace

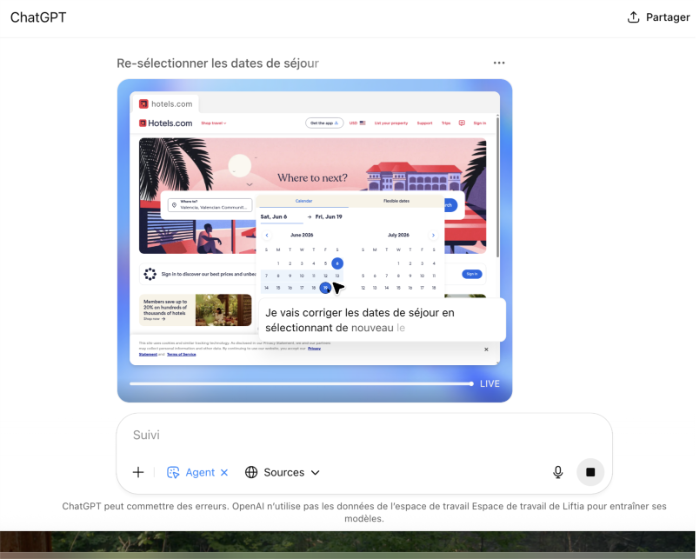

Quand on lance le nouvel agent d’OpenAI, il propose de nous aider à réserver nos vacances. Alors évidemment, j’ai confié à l’agent la mission d’organiser un voyage fictif pour juin prochain.

Une fenêtre s’ouvre. On voit l’agent naviguer sur Internet en temps réel, cliquer, chercher, comparer. L’effet wow est immédiat : l’agent commente ses actions, affiche les obstacles qu’il rencontre, et avance étape par étape.

Mais après quelques minutes, une question me hante : quel est le vrai gain ?

Voir l’IA faire défiler Booking.com sous mes yeux, c’est fascinant… mais pas forcément efficace. C’est un peu comme demander à ma grand-mère (ou à ma nièce de 7 ans) de réserver un hôtel à ma place, tout en observant son écran. Résultat : beaucoup d’erreurs, peu d’autonomie, et surtout aucun gain de temps. Si gain il y a, c’est surtout en frustration.

Et côté productivité ?

Deuxième test : l’agent peut-il envoyer un courriel pour moi ? L’idée, vendue partout, c’est celle d’un assistant centralisé, capable de gérer nos tâches dans une seule interface : ChatGPT.

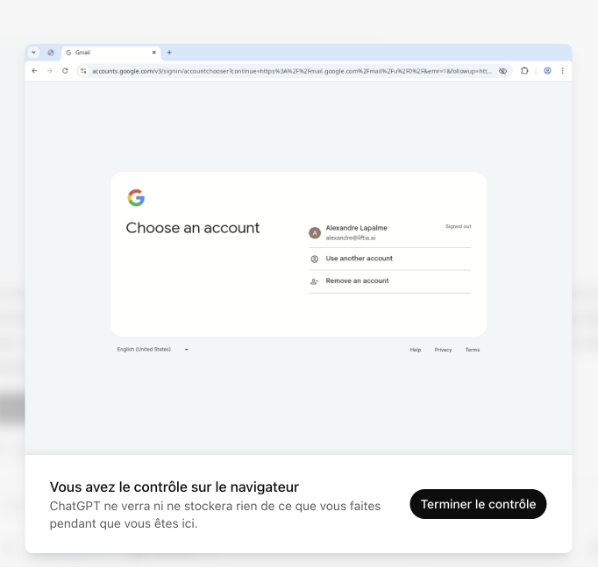

Je demande donc à l’outil d’accéder à ma boîte courriel. Nouvelle fenêtre. La machine me demande alors de prendre le contrôle de mon ordinateur… pour que je rentre moi-même mes identifiants.

Déjà, on comprend que l’automatisation a ses limites. Mais surtout, un nouveau dilemme apparaît : faut-il tout donner à l’agent pour qu’il soit performant ? Données sensibles, mots de passe, accès à nos comptes…

Une fois connecté, un avertissement m’indique que je manipule des données sensibles. J’ai réussi à envoyer un courriel (et j’en ai profité pour changer mon mot de passe). Mais soyons honnêtes : j’aurais fait tout ça bien plus vite sans l’agent. Et une autre question, plus préoccupante, se pose : et la protection des données dans tout ça ?

Comment concilier agent performant et confidentialité ?

C’est la grande question. Comment démocratiser l’accès à des agents réellement utiles et performants, s’ils doivent accéder à nos données les plus sensibles pour fonctionner efficacement ?

Je repense aux débats animés autour de la Loi 25, sur la protection des renseignements personnels au Québec. On avait beaucoup parlé de consentement, de transparence, de gouvernance des données… Aujourd’hui, ces préoccupations semblent reléguées au second plan, éclipsées par l’emballement technologique.

Et pourtant, les signaux d’alerte ne manquent pas. Il n’y a pas si longtemps, Sam Altman évoquait publiquement que les informations transmises à ChatGPT pourraient être utilisées devant les tribunaux. On apprenait récemment que certaines conversations avec ChatGPT étaient indexées dans Google. L’option a été désactivée depuis le 1er août, mais ça reste révélateur : il y a un flou inquiétant sur la gestion des paramètres de confidentialité et plus largement, sur la confiance qu’on peut accorder à ces technologies. Je me demande sincèrement comment ils comptent concilier performance et protection des données, sans que l’un ne vienne cannibaliser l’autre.

Et si on automatisait les mauvaises tâches ?

Soyons clairs : le mode agent de ChatGPT est impressionnant. Visuellement, techniquement, il marque une étape importante. Mais à ce jour, il peine à démontrer son utilité concrète. Difficile d’affirmer qu’il améliore véritablement notre productivité.

Personnellement, j’aurais préféré que les grandes boîtes californiennes concentrent leurs efforts sur des agents capables de faire mon lavage ou de tondre ma pelouse. Là, oui, j’embarque. Mais réserver un voyage à ma place ? Envoyer un courriel de suivi ? Je me demande sincèrement si c’est vraiment ça, les problèmes que les gens veulent voir résolu par l’IA.

D’un côté, on nous promet une révolution : l’IA va changer nos vies, bouleverser le monde du travail, réinventer nos routines. Et ce discours, poussé par les big tech, alimente en retour un contre-discours apocalyptique : l’IA serait désormais si puissante qu’elle met en péril les fondements mêmes de la société humaine.

Mais en ce mois d’août 2025, ce que je vois, c’est un agent qui peine à accomplir des tâches somme toute banales… on est encore loin de la révolution annoncée…

Entre le rêve de l’IA et la réalité du terrain

Je n’ai pas de boule de cristal, et LinkedIn regorge déjà de prophètes de l’IA : certains nous prédisent un futur à la Skynet, d’autres un monde radieux sous assistance algorithmique. Nous, chez Liftia, on se situe entre les deux.

L’IA continuera d’évoluer, de progresser : c’est certain. Mais pour que les agents deviennent plus qu’un gadget, il faudra résoudre ce problème fondamental : comment créer des outils autonomes, efficaces, intelligents… sans compromettre notre sécurité, notre autonomie ni notre capacité à réfléchir par nous-mêmes ?

Le vrai défi, c’est peut-être de redescendre sur terre. Et de se demander : qu’est-ce qu’on veut vraiment que l’IA accomplisse pour nous ?

Alexandre Lapalme est consultant en intelligence artificielle chez Liftia, où il conçoit des contenus de formation et accompagne les organisations dans l’adoption réfléchie des technologies IA. Liftia est une jeune entreprise basée en France et au Canada, spécialisée en formation et en accompagnement sur mesure en intelligence artificielle.